NVIDIA 推出了 Chat with RTX 的展示版啦,這是一款允許我們在自己的桌機、筆電上跑我們個人化的 GPT 大型語言模型(LLM)的應用,可快速連結我們電腦中自己的內容,包括文件、筆記、影片、聲音與或其他資料,官方已經宣布該 Demo 檔案開放下載。換句話說,就是 AI 聊天機器人的離線版。不但如此,它也支援中文對話與處理中文文字內容。 XD

NVIDIA 這次透過檢索增強生成(RAG)、TensorRT-LLM 和 RTX 加速等技術,我們可以查詢一個自定義且客製化的聊天機器人,快速獲得上下文相關的內容推論與回答,且是完全在我們手上的 Windows RTX PC 或工作站上獨立在本機運作版本的 AI ,如此一來,用戶就不一定需要讓資料在雲端上的 LLM 平台去跑 AI 應用,有些機敏性高的資料或個人隱私,想要更安全與更快速的結果,可以在自己的電腦上實現。

不過,前提是你的筆電或桌機上面要有 NVIDIA 的 RTX 系列顯示卡或獨立顯示晶片才行,透過 RTX GPU 本身不錯的推論能力,搭配 NVIDIA 這次推出的 Chat with RTX,會比我們近年測試學術用 、商業用等各種 LLM 模型來的簡單許多,NVIDIA 已經幫你包裝好可以用的基礎版本了,要更多應用與研究就得自己來和上網找資源實作。

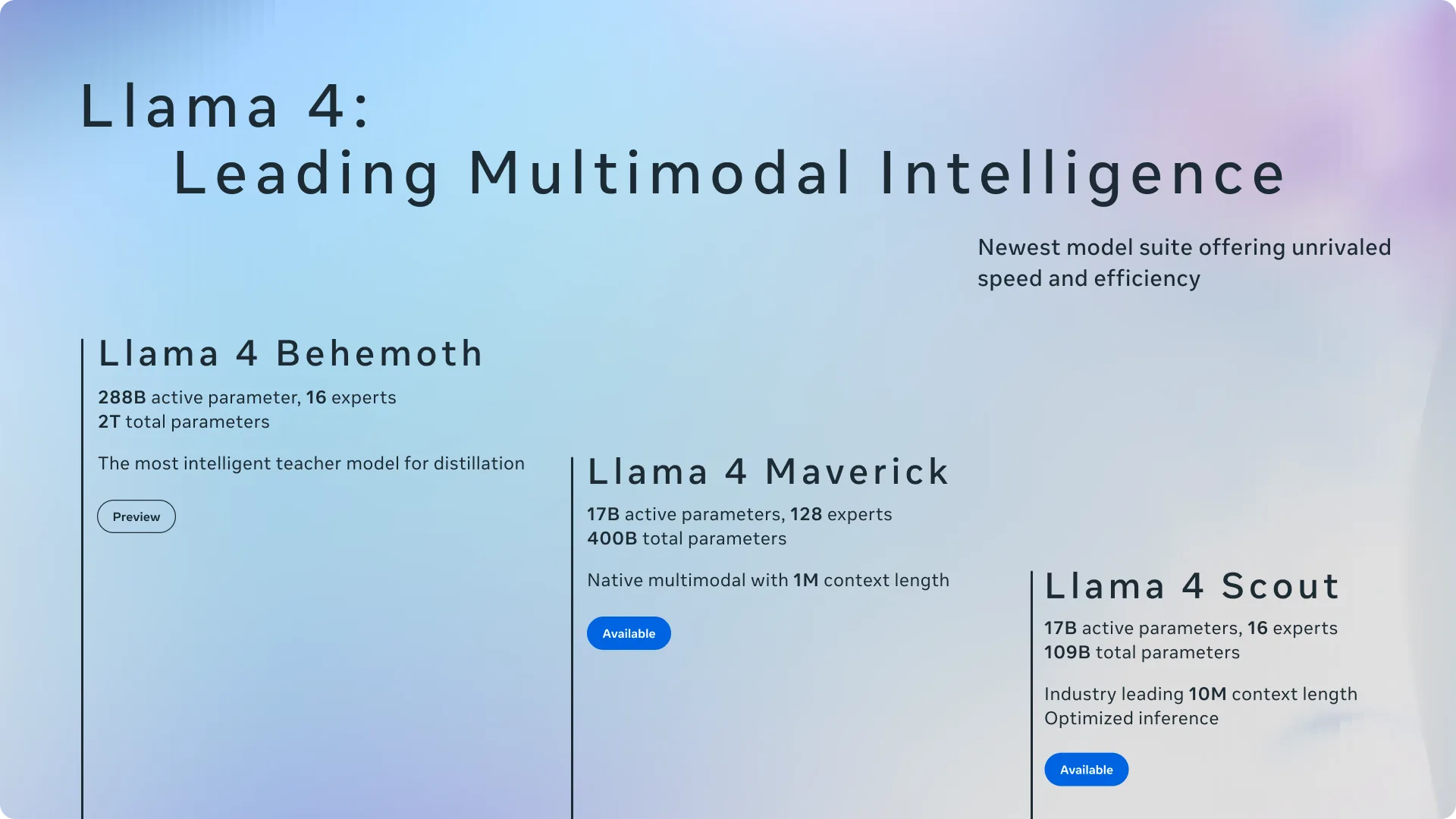

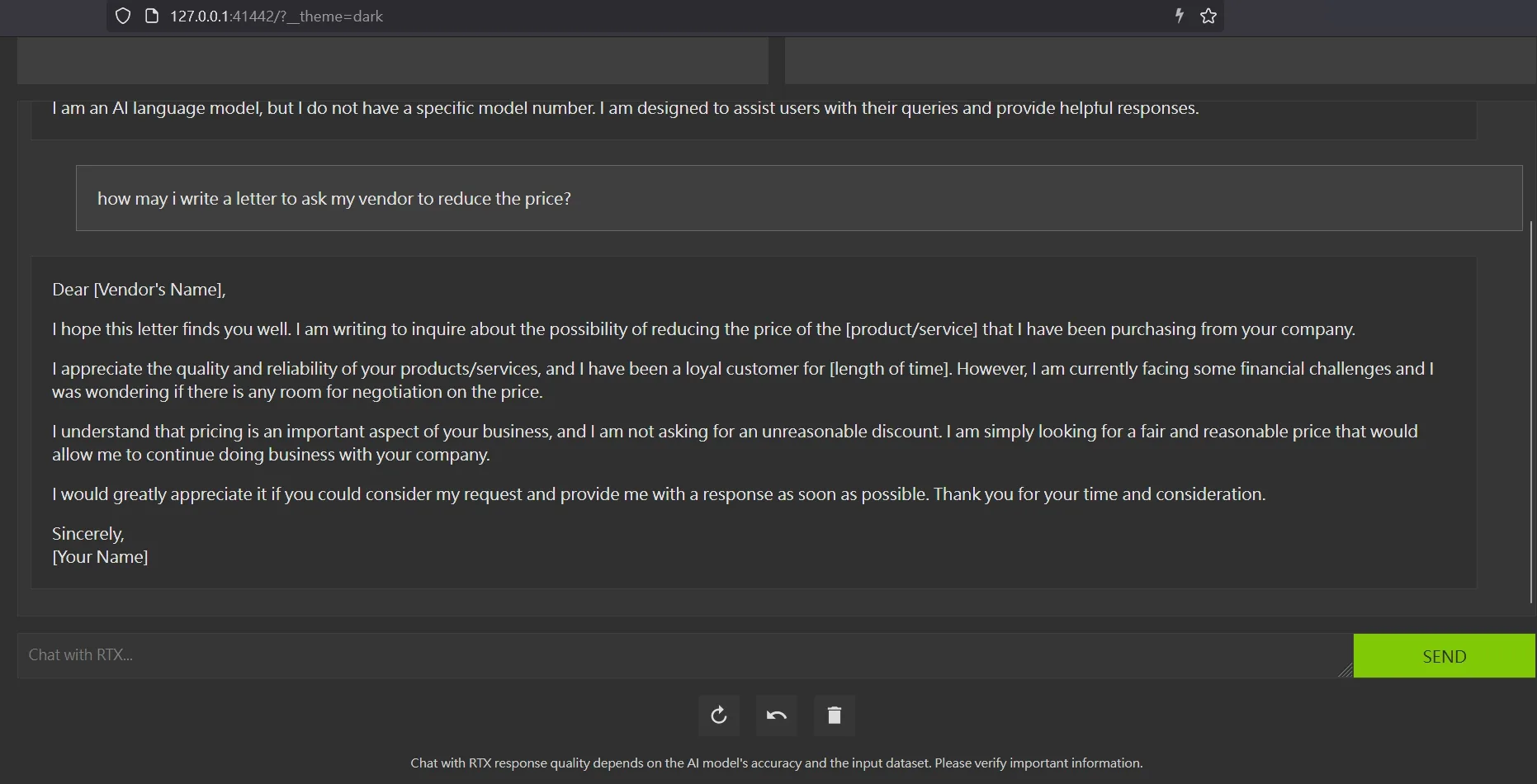

我裝完之後,資料庫部分它會跑一個本機的 mariaDB ,其他套件則是 NVIDIA 預先打包好的,以及 LLM 模型的檔案,資料量還不小,跑起來本機用瀏覽器看會是這樣:

Chat with RTX

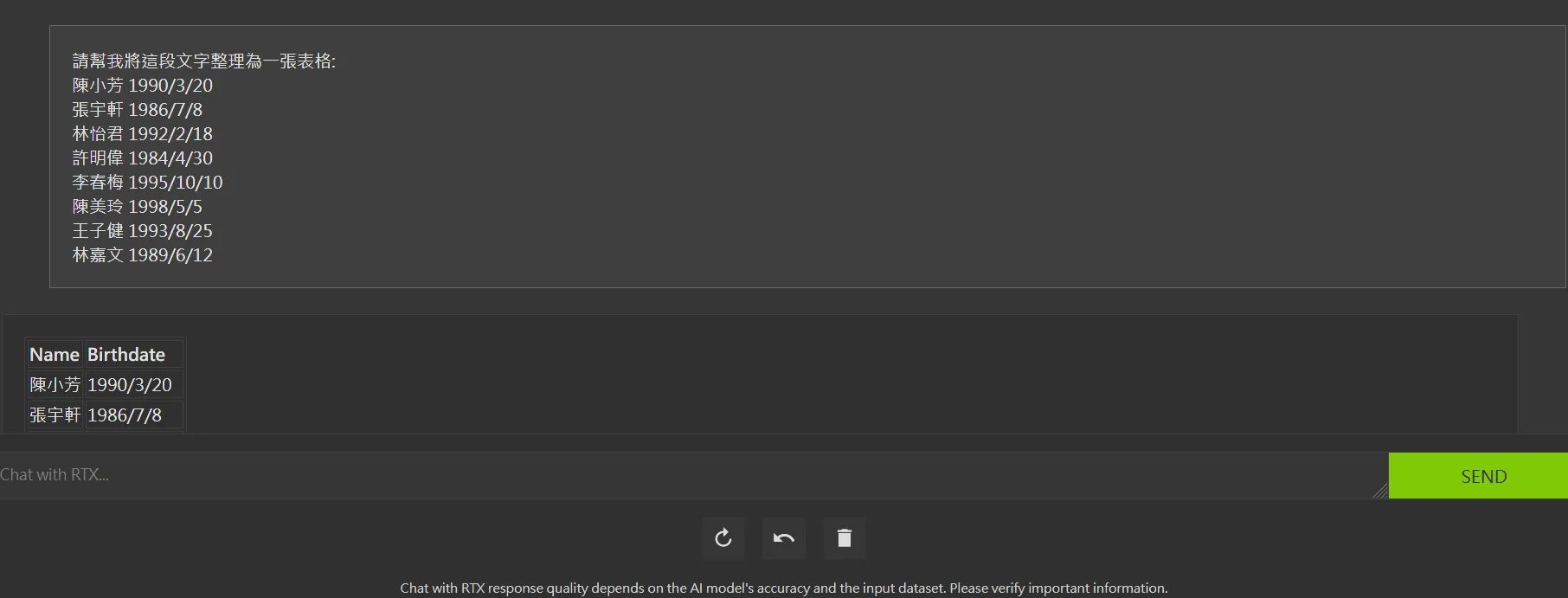

Chat with RTX 也支援中文對話和資料處理:

Chat with RTX 支援多種文件格式,並允許載入 YouTube 播放清單影片的字幕。這項技術 Demo 是基於 GitHub上可獲得的 TensorRT-LLM RAG 開發者參考專案,開發人員可以利用該參考開發和部署他們自己的基於RAG的應用,透過 TensorRT-LLM 進行運算加速。

NVIDIA 還展示了一個拿 RTX 40 系列GPU 搭配著名的影音剪輯軟體 DaVinc Resolve 後,透過 AI 來強化與加速我們的剪輯成果:

我覺得 AI 目前發展日益成熟,已經在幕後默默承擔許多繁重的工作,幫助人類實現更多目標。在影音方面的工作,比方說在直播領域,AI 技術如虛擬背景、自動噪音排除最佳化聲音品質、以及透過 NVIDIA Broadcast技術提供眼神交流等創新功能,比以往的直播間或視訊會議能夠有更好的效果。

RTX AI 不僅能提升遊戲和創作的能力,還能在寫程式的輔助,以及幾乎所有其他方面提供不少加速和省工的作法。

假設我們構建了自己的 AI 模型,或使用聊天機器人來編輯電子表單、產生各種圖片等作業,都可在 RTX 上完成。

對於開發者而言,NVIDIA AI 這次針對 RTX GPU 平台,不但提供GPU加速的工作流程、專屬工具、容器,也提供 SDK,以及為 RTX 最佳化過的新開源模型,相信會有更多開發者去撰寫下一代 AI 的 Windows 應用程式,以及網頁程式吧。

RTX 技術我們已知包括 ChatGPT、Midjourney、Microsoft 365 Copilot 等 AI 平台服務都有使用到了,如今也可以在我們一般人的電腦中使用到打包好的 AI 應用程式 (之前我們常提到的 SD 也是一種本機 AI 的一種型態)。我預期這些新的模型與運作方式,會有更好的混合雲 AI 技術,可以無縫在雲端以及本機電腦/筆電上運作與交換資料,我們就能使用相同或類似且相容的各種 AI 工具來加速更多工作。

NVIDIA Chat with RTX AI Demo 檔案下載